💡 이글은Engineering at Meta 사이트에 2025년 11월 10일에 게재된 Meta’s Generative Ads Model (GEM): The Central Brain Accelerating Ads Recommendation AI Innovation 콘텐츠를 한글로 번역한 콘텐츠 입니다.

Meta의 Generative Ads Recommendation Model (GEM)은 광고 성과와 광고주 ROI를 향상하기 위해 설계된 대규모 Foundation Model입니다. GEM은 확장 가능한 아키텍처, 고도화된 Post-training 기술, 그리고 효율적인 학습 인프라를 활용하여 더욱 관련성 높고 개인화된 광고 경험을 제공합니다. 런칭 이후, GEM은 Instagram과 Facebook에서 광고 Conversion의 유의미한 증가를 견인했습니다.

저자: Huayu Li, Xiaoyi Liu, Jade Nie, Ellie Wen, Chunzhi Yang, Jiyan Yang, Nancy Yu, Habiya Beg, Gil Arditi, Neeraj Bhatia (2025년 11월 10일)

우리는 다른 광고 추천 모델들이 관련성 높은 광고를 제공하는 능력을 향상시켜, 광고 성과와 광고주 ROI를 높이는 새로운 Foundation Model인 Meta의 Generative Ads Recommendation Model (GEM)에 대한 세부 정보를 공유합니다.

- GEM의 새로운 아키텍처는 파라미터 수가 증가함에 따라 확장(Scale)이 가능하며, 일관되게 더 정밀한 예측을 효율적으로 생성할 수 있게 합니다.

- GEM은 전체 광고 모델(Ads Model Fleet)에 걸쳐 일련의 Post-training 기술을 활용해 학습 내용을 전파하며, Meta의 광고 추천 시스템(Ads Recommendation System)의 패러다임 전환을 가능하게 합니다.

- GEM은 향상된 학습 확장성(Scalability)을 활용하여 LLM 스케일의 광고 Foundation Model을 구축하고 반복(Iterating)하는 데 수천 개의 GPU를 효율적으로 사용합니다.

- GEM은 이미 Instagram과 Facebook 전반에서 광고 Conversion의 상당한 증가를 이끌어내고 있습니다.

Meta는 제품과 서비스 전반에 걸쳐 AI를 활용하여 광고주를 위한 비즈니스 가치를 창출하는 데 앞장서 왔습니다. 사용자에게 광고를 개인화하고 각 광고 노출(Impression)의 성과를 극대화하기 위해 고급 기술을 활용하는 것은 우리가 광고 추천 시스템을 개발하는 방식의 핵심입니다.

Generative Ads Recommendation Model (GEM)은 Meta의 가장 진보된 광고 Foundation Model로, LLM에서 영감을 받은 패러다임을 기반으로 구축되었으며 수천 개의 GPU에서 학습됩니다. 이는 업계 최대 규모의 추천 시스템(RecSys) Foundation Model로, 대규모 언어 모델(LLM)의 스케일로 학습되었습니다. GEM은 효율적인 Scaling Law를 여는 아키텍처 혁신을 도입하여, 데이터와 컴퓨팅 자원에 비례해 비용 효율적으로 확장되는 성능 이점을 제공합니다. 다차원 병렬화(Multi-dimensional Parallelism), 커스텀 GPU 커널, 메모리 최적화와 같은 학습 분야의 돌파구들이 GEM을 이 정도 규모로 학습하는 것을 가능하게 했습니다.

Post-training 단계에서 GEM은 고급 지식 전이(Knowledge Transfer) 기술을 적용하여 전체 광고 스택(Ads Stack)의 다운스트림 모델(Downstream Models) 성능을 증폭시킵니다. 이를 통해 사용자의 선호에 맞춘 더욱 관련성 높고 개인화된 광고 경험을 제공합니다. 2025년 초 GEM을 런칭한 이후, Facebook과 Instagram에 적용된 GEM은 2분기 기준 Instagram에서 5%, Facebook Feed에서 3%의 광고 Conversion 증가를 달성했습니다.

3분기에는 GEM의 모델 아키텍처를 개선하여, 데이터와 컴퓨팅 자원을 추가할 때 얻을 수 있는 성능 이점을 두 배로 늘렸습니다. 이를 통해 우리는 매력적인 ROI를 유지하며 GEM에 사용하는 학습 용량을 지속적으로 확장할 수 있게 되었습니다.

GEM 소개 (Introducing GEM)

GEM은 세 가지 핵심 혁신을 통해 RecSys의 중대한 진보를 나타냅니다. 1) 고도화된 아키텍처를 통한 모델 스케일링, 2) 지식 전이를 위한 Post-training 기술, 3) 확장성을 지원하는 향상된 학습 인프라가 그것입니다. 이러한 혁신들은 광고 성과를 효율적으로 부스팅하고, 광고 모델 전반에 걸친 효과적인 지식 공유를 가능하게 하며, 학습을 위한 수천 개의 GPU 사용을 최적화합니다. GEM은 광고 RecSys의 패러다임 전환을 주도하여, 사용자 목표와 광고주 목표의 결합 최적화(Joint Optimization)를 통해 인지(Awareness), 참여(Engagement), 전환(Conversion) 등 퍼널(Funnel) 전반의 광고 성과를 변화시켰습니다.

Meta의 광고 RecSys를 위한 대규모 Foundation Model을 구축하려면 다음과 같은 주요 과제들을 해결해야 합니다:

- Meta의 모든 앱에 걸친 방대하고 동적인 기능 공간(Feature Space) 처리: 매일 우리 플랫폼 전반에서 수십억 건의 사용자-광고 상호작용이 발생하지만, 클릭이나 Conversion과 같은 의미 있는 신호는 매우 희소(Sparse)합니다. GEM은 이 방대하지만 불균형한 데이터로부터 학습하여 의미 있는 패턴을 인식하고 다양한 사용자와 행동에 대해 일반화(Generalize)해야 합니다.

- 다양한 데이터 배열 처리: GEM은 광고주 목표, 크리에이티브 포맷, 측정 신호(Measurement Signals), 그리고 여러 전달 채널에 걸친 사용자 행동을 포함한 다양한 광고 데이터로부터 학습해야 합니다. 이러한 이질성(Heterogeneity)은 모델링 복잡성을 크게 가중시키며, GEM이 멀티모달, 멀티 소스 입력을 통합하고 미세한 상호작용을 포착하여 다른 광고 추천 모델들을 지원(Power)하도록 요구합니다.

- 효율적인 학습: 대규모 Foundation Model을 학습시키고 확장하는 것은 수천 개의 GPU를 필요로 하며, 효율적인 하드웨어 활용을 보장하기 위해 고도화된 병렬화(Parallelism)와 시스템 레벨의 최적화를 활용해야 합니다.

GEM은 다음과 같은 방법으로 이러한 과제들을 극복합니다:

- 주어진 데이터와 컴퓨팅 자원 양에 대해 기존 광고 추천 랭킹 모델보다 광고 성과 향상 효율이 4배 더 높은 확장 가능한 모델 아키텍처.

- 표준 Knowledge Distillation 대비 2배의 효과를 달성하며 지식 전이 효과를 개선하는 새로운 프레임워크.

- 16배 더 많은 GPU를 사용하면서 모델 FLOPS Utilization (MFU)을 1.43배 증가시키고, 유효 학습 FLOPS를 23배 증가시킨 새로운 학습 스택.

GEM 아키텍처 구축 및 확장 (Building and Scaling GEM’s Architecture)

GEM은 광고 및 유기적(Organic) 상호작용에서 얻은 광고 콘텐츠와 사용자 참여(Engagement) 데이터를 기반으로 학습됩니다. 이 데이터로부터 우리는 시퀀스 기능(Sequence Features, 예: 활동 기록)과 비시퀀스 기능(Non-sequence Features, 예: 연령, 위치, 광고 포맷, 크리에이티브 표현 등 사용자 및 광고 속성)의 두 그룹으로 분류되는 특징(Features)을 도출합니다. 각 그룹에는 맞춤형 어텐션 메커니즘(Attention Mechanisms)이 독립적으로 적용되는 동시에, 교차 기능 학습(Cross-feature Learning)도 가능하게 합니다. 이 설계는 정확도를 높이고 각 어텐션 블록의 깊이와 너비를 모두 확장하여 이전 세대 모델 대비 4배의 효율성을 제공합니다.

비시퀀스 기능 상호작용 모델링 (Non-Sequence Feature Interaction Modeling)

사용자 속성이 광고 특성과 어떻게 상호작용하는지 이해하는 것은 정확한 추천을 위해 매우 중요합니다. GEM은 Wukong 아키텍처를 개선하여 교차 레이어 어텐션 연결(Cross-layer Attention Connections)이 있는 스택형 인수분해 머신(Stackable Factorization Machines)을 사용함으로써, 모델이 어떤 기능 조합이 가장 중요한지 학습할 수 있게 합니다. 각 Wukong 블록은 수직적(더 깊은 상호작용) 및 수평적(더 넓은 기능 커버리지)으로 확장 가능하여 점점 더 복잡해지는 사용자-광고 패턴을 발견할 수 있습니다.

오프라인 시퀀스 기능 모델링 (Offline Sequence Feature Modeling)

광고/콘텐츠 클릭, 조회 및 상호작용의 긴 시퀀스에 걸친 사용자 행동 시퀀스(User Behavior Sequences)는 선호도와 의도(Intent)에 대한 풍부한 신호를 포함하고 있지만, 전통적인 아키텍처는 이러한 긴 시퀀스를 효율적으로 처리하는 데 어려움을 겪습니다. GEM은 피라미드 병렬(Pyramid-parallel) 구조로 이 문제를 극복하며, 여러 병렬 상호작용 모듈을 피라미드 형태로 쌓아 복잡한 사용자-광고 관계를 대규모로 포착합니다. 새로운 확장 가능한 오프라인 기능 인프라는 최소한의 스토리지 비용으로 최대 수천 개의 이벤트 시퀀스를 처리하므로, GEM은 훨씬 더 긴 사용자 유기적/광고 상호작용 기록으로부터 학습할 수 있습니다. 이러한 확장된 사용자 행동 시퀀스를 모델링함으로써, GEM은 패턴과 관계를 더 효과적으로 발견하여 사용자의 구매 여정(Purchase Journey)에 대해 더 깊고 정확하게 이해할 수 있습니다.

교차 기능 학습 (Cross-Feature Learning)

기존 접근 방식은 다운스트림 작업을 위해 사용자 행동 시퀀스를 압축된 벡터로 변환하는데, 이는 중요한 참여(Engagement) 신호를 잃을 위험이 있습니다. GEM은 전체 시퀀스 정보를 보존하면서 효율적인 교차 기능 학습을 가능하게 하는 다른 접근 방식을 취합니다. 우리의 설계인 InterFormer는 시퀀스 학습(예: 커스텀 트랜스포머 아키텍처)과 교차 기능 상호작용 레이어 사이를 교차하는 구조(Interleaving Structure)를 가진 병렬 요약(Parallel Summarization)을 채택합니다. 이는 전체 사용자 여정에 대한 접근을 유지하면서 시퀀스 이해를 점진적으로 정교화할 수 있게 합니다. 이 설계는 사용자 시퀀스 데이터의 구조적 무결성을 보존하면서 효율적인 상호작용 학습을 촉진하여, GEM이 중요한 행동 신호를 잃지 않고 더 높은 레이어 수로 확장할 수 있게 합니다.

도메인별 최적화를 통한 멀티 도메인 학습 (Multi-Domain Learning With Domain-Specific Optimization)

전통적인 광고 추천 시스템은 광범위한 제품 생태계 전반에서 학습 균형을 맞추는 데 어려움을 겪어왔습니다. 표면(Surfaces)을 고립된 것으로 취급하거나(귀중한 교차 플랫폼 인사이트 누락), 동일하게 취급(플랫폼별 행동 무시)했기 때문입니다. Facebook, Instagram, Business Messaging과 같은 서로 다른 Meta의 표면들은 각각 고유한 사용자 행동과 상호작용 패턴을 가집니다. GEM은 표면 간 사용자 상호작용(Cross-surface User Interactions)으로부터 학습하는 동시에 예측이 각 표면의 고유한 특성에 맞춰지도록 보장함으로써 이 문제를 해결합니다. 예를 들어, 이를 통해 GEM은 Instagram 비디오 광고 참여에서 얻은 인사이트를 사용하여 Facebook Feed 광고 예측을 개선하는 동시에, 각 도메인의 예측을 특정 목표(클릭 또는 Conversion 등)에 맞게 최적화할 수 있습니다.

Post-Training 기술로 전이 효율성 극대화 (Maximizing Transfer Efficiency With Post Training Techniques)

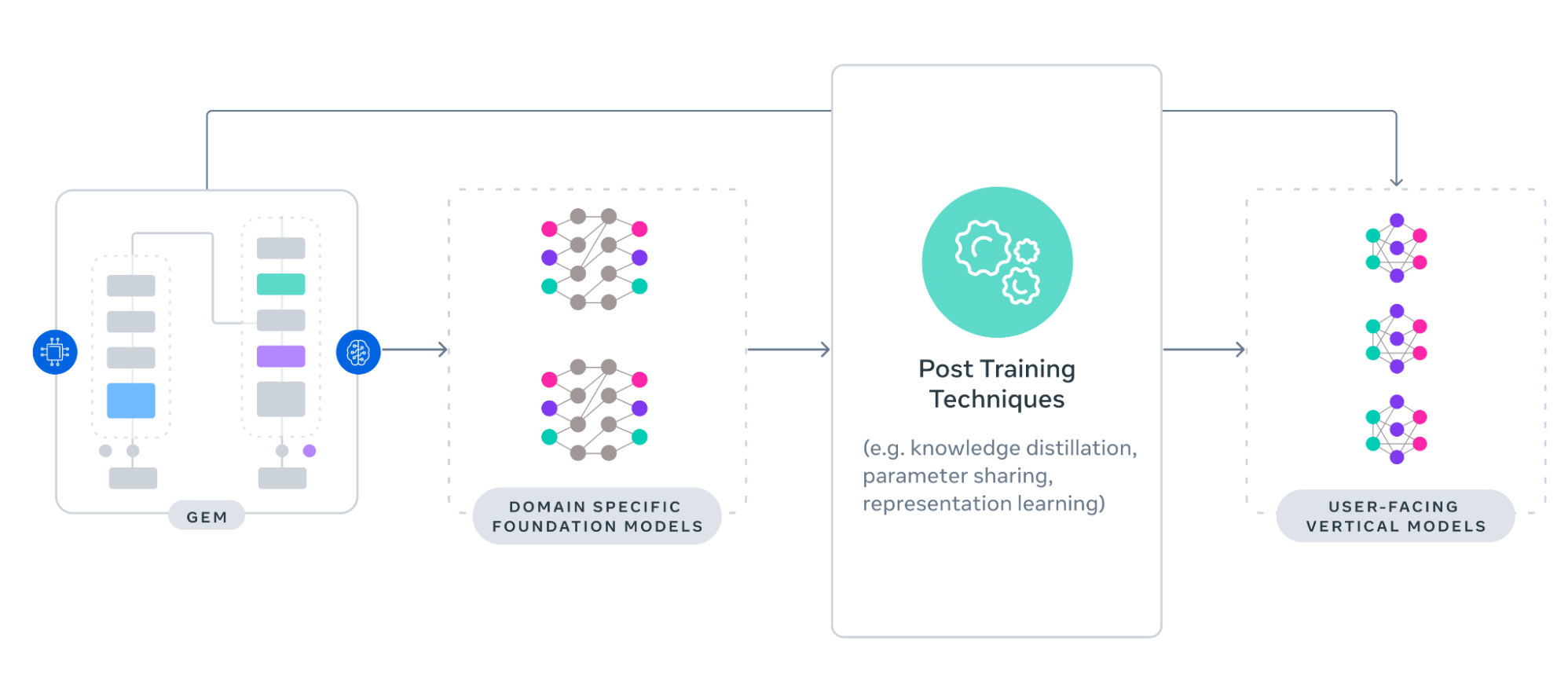

GEM은 그 지식이 수백 개의 사용자 대면 Vertical Models (VMs)로 효율적으로 전이될 때 비로소 영향력을 발휘합니다. GEM Foundation Model (FM)의 성능을 사용자 대면 VM의 측정 가능한 이익으로 변환하기 위해, 우리는 직접(Direct) 및 계층적(Hierarchical) 지식 전이 전략을 모두 사용합니다.

직접 전이는 GEM이 학습된 동일한 데이터 공간 내의 주요 VM으로 지식을 전이할 수 있게 합니다. 계층적 전이는 GEM의 지식을 도메인 특화 FM으로 증류(Distill)하고, 이들이 다시 VM을 가르쳐 광고 모델 전반에 걸친 광범위한 개선을 이끌어냅니다. 이 접근 방식들은 Knowledge Distillation, Representation Learning, Parameter Sharing을 포함한 일련의 기술을 함께 사용하여 전체 광고 모델 공간에서 전이 효율성을 극대화하며, 표준 Knowledge Distillation 대비 2배의 효과를 달성합니다.

지식 증류 (Knowledge Distillation)

Meta의 광고 시스템에서 VM들은 FM 학습 및 평가의 지연, 그리고 GEM 또는 FM 예측과 VM의 표면별 목표 간의 도메인 불일치로 인해 종종 오래된 감독(Stale Supervision) 문제를 겪습니다. 이러한 VM(학생)과 GEM(교사) 사이의 오래되거나 정렬되지 않은 신호는 시간이 지남에 따라 학생 모델의 정확도와 적응성을 저하시킬 수 있습니다.

이를 해결하기 위해 우리는 학습 중에 Student Adapter를 사용합니다. 이는 가장 최근의 Ground-truth 데이터를 사용하여 교사의 출력(Outputs)을 정제하는 경량 구성 요소입니다. 이는 교사의 예측을 관찰된 결과와 더 잘 일치시키는 변환(Transformation)을 학습하여, 학생 모델이 학습 전반에 걸쳐 더 최신의 도메인 관련 감독을 받도록 보장합니다.

표현 학습 (Representation Learning)

Representation Learning은 모델이 원시 데이터로부터 의미 있고 압축된 특징(Features)을 자동으로 도출하여 광고 클릭 예측과 같은 다운스트림 작업을 더 효과적으로 수행하게 하는 과정입니다. Representation Learning은 의미적으로 정렬된 특징을 생성하여 Knowledge Distillation을 보완하며, 교사에서 학생 모델로의 효율적인 지식 전이를 지원합니다. 이 접근 방식을 통해 GEM은 추론(Inference) 오버헤드를 추가하지 않고도 FM에서 VM으로의 전이 효율성을 효과적으로 개선할 수 있습니다.

파라미터 공유 (Parameter Sharing)

Parameter Sharing은 여러 모델이나 구성 요소가 동일한 파라미터 세트를 재사용하여 중복을 줄이고 효율성을 개선하며 지식 전이를 촉진하는 기술입니다.

우리의 맥락에서 Parameter Sharing은 VM이 FM의 구성 요소를 선택적으로 통합할 수 있게 하여 효율적인 지식 재사용을 가능하게 합니다. 이를 통해 더 작고 지연 시간(Latency)에 민감한 VM들이 전체 계산 비용을 부담하지 않고도 FM의 풍부한 표현(Representations)과 사전 학습된 패턴을 활용할 수 있습니다.

GEM 학습 방법 (How GEM Was Trained)

GEM은 일반적으로 최신 LLM에서나 볼 수 있는 규모로 운영됩니다. GEM을 학습시키기 위해서는 학습 레시피(Training Recipes)의 전면적인 개편이 필요했습니다. 재설계된 학습 스택은 16배 더 많은 GPU를 사용하면서 유효 학습 FLOPs를 23배 증가시키고 효율성 또한 개선했습니다. 하드웨어 효율성의 주요 지표인 MFU는 1.43배 증가하여 GPU 자원의 더 나은 활용을 반영했습니다. 처리량(Throughput)과 효율성을 동시에 높이는 이러한 능력은 이 규모의 Foundation Model을 학습시키는 데 중요합니다.

거대한 모델 크기와 멀티모달 워크로드를 지원하기 위해 우리는 다차원 병렬화(Multi-dimensional Parallelism), 커스텀 GPU 커널, 모델-시스템 공동 설계(Model-system Co-design)와 같은 전략을 채용합니다. 이러한 기술들은 수천 개의 GPU에 적용되어 거의 선형적인(Near-linear) 확장을 가능하게 하며, 컴퓨팅 처리량, 메모리 사용량, 전반적인 하드웨어 효율성을 개선합니다.

분산 학습 (Distributed Training)

GEM과 같은 대규모 모델을 학습시키려면 고밀도(Dense) 및 희소(Sparse) 구성 요소 모두에 걸쳐 신중하게 조율된 병렬화 전략이 필요합니다. 모델의 Dense 부분에 대해서는 HSDP(Hybrid Sharded Distributed Parallel)와 같은 기술이 메모리 사용량을 최적화하고 통신 비용을 줄여, 수천 개의 GPU에 걸쳐 Dense 파라미터를 효율적으로 분배할 수 있게 합니다. 대조적으로, 주로 사용자 및 아이템 기능을 위한 대규모 임베딩 테이블인 Sparse 구성 요소는 데이터 병렬화(Data Parallelism)와 모델 병렬화(Model Parallelism)를 사용하는 2차원 접근 방식을 채택하여 동기화 효율성과 메모리 지역성(Locality)을 최적화합니다.

GPU 처리량을 위한 시스템 수준 최적화 (System-Level Optimizations for GPU Throughput)

병렬화 외에도 GPU 컴퓨팅 처리량을 포화 상태로 만들고 학습 병목 현상을 줄이기 위해 일련의 기술을 구현했습니다:

- 가변 길이(Jagged)의 사용자 시퀀스와 연산 융합(Computation Fusion)을 위해 설계된 사내 커스텀 GPU 커널로, 최신 GPU 하드웨어 기능과 최적화 기술을 활용합니다.

- 메모리 절약을 위한 Activation Checkpointing과 실행 효율성 향상을 위한 Operator Fusion을 포함한 주요 최적화를 자동화하는 PyTorch 2.0의 그래프 레벨 컴파일.

- 메모리 사용량(Footprint)을 줄이기 위한 활성화(Activations)용 FP8 양자화 및 통합 임베딩 포맷과 같은 메모리 압축 기술.

- 또한, NCCLX(NVIDIA NCCL의 Meta 포크)를 통해 SM(Streaming Multiprocessor) 자원을 사용하지 않고 작동하는 GPU 통신 집합체(Collectives)를 개발하여 통신과 연산 워크로드 간의 경합을 제거하고 오버랩 및 GPU 활용도를 개선했습니다.

학습 오버헤드 및 작업 시작 시간 단축 (Reducing Training Overhead and Job Startup Time)

학습 민첩성을 높이고 GPU 유휴 상태를 최소화하기 위해, 우리는 새로운 데이터를 처리하는 데 소비되는 학습 시간의 비율인 유효 학습 시간(ETT)을 최적화했습니다. Trainer 초기화, 데이터 리더 설정, Checkpointing, PyTorch 2.0 컴파일 시간 등을 최적화하여 작업 시작 시간을 5배 단축했습니다. 특히 캐싱 전략을 통해 PyTorch 2.0 컴파일 시간을 7배 줄였습니다.

개발 생애주기 전반에 걸친 GPU 효율성 극대화 (Maximizing GPU Efficiency Across the Development Lifecycle)

GPU 효율성은 초기 실험부터 대규모 학습 및 Post-training에 이르는 모델 생애주기의 모든 단계에서 최적화됩니다. 탐색 단계에서는 풀 사이즈 모델에 비해 훨씬 낮은 비용으로 경량 모델 변형(Variants)을 사용하여 반복(Iteration)을 가속화합니다. 이러한 변형들은 전체 실험의 절반 이상을 지원하며, 최소한의 자원 오버헤드로 빠른 아이디어 검증을 가능하게 합니다. Post-training 단계에서 모델은 Forward Pass를 실행하여 다운스트림 모델을 위한 레이블 및 임베딩과 같은 지식을 생성합니다. 대규모 언어 모델과 달리, 우리는 FM을 갱신(Refresh)하기 위해 지속적인 온라인 학습도 수행합니다. 우리는 학습과 Post-training 지식 생성 간, 그리고 Foundation Model과 다운스트림 모델 간의 트래픽 공유를 강화하여 계산 수요를 줄입니다. 또한, 엔드투엔드 시스템 처리량을 개선하기 위해 모든 단계에 GPU 효율성 최적화가 적용되었습니다.

광고 추천을 위한 Foundation Model의 미래 (The Future of Foundation Models for Ads Recommendations)

광고 추천 시스템의 미래는 사람들의 선호와 의도에 대한 더 깊은 이해로 정의될 것이며, 모든 상호작용을 개인적인 것처럼 느끼게 할 것입니다. 광고주에게 있어 이는 대규모의 일대일 연결로 이어져 더 강력한 참여(Engagement)와 성과(Outcomes)를 견인합니다.

앞으로 GEM은 텍스트, 이미지, 오디오, 비디오와 같은 모달리티 전반에 걸친 유기적 및 광고 콘텐츠에서의 사용자 상호작용을 포함하여 Meta의 전체 생태계로부터 학습할 것입니다. 이러한 GEM의 학습 내용은 Facebook과 Instagram의 모든 주요 표면을 커버하도록 확장될 것입니다. 더 강력해진 멀티모달 기반은 GEM이 클릭, Conversion, 장기적 가치(LTV) 이면의 미묘한 차이를 포착하도록 도울 것이며, 유기적 콘텐츠와 광고를 모두 지능적으로 랭킹 매길 수 있는 통합 참여 모델(Unified Engagement Model)을 위한 길을 열어 사람들과 광고주에게 최대의 가치를 제공할 것입니다.

우리는 아키텍처를 발전시키고 최신 AI 하드웨어에서 학습 레시피를 진보시킴으로써 GEM을 지속적으로 확장하고 더 큰 클러스터에서 학습시킬 것이며, 이를 통해 다양한 모달리티를 가진 더 많은 데이터로부터 효율적으로 학습하여 정밀한 예측을 제공할 것입니다. 또한 우리는 GEM을 진화시켜 Inference-time Scaling으로 추론하고 컴퓨팅 할당을 최적화하며, 의도 중심(Intent-centric)의 사용자 여정을 지원하고, 더 높은 ROAS를 견인하는 에이전트형(Agentic), 인사이트 주도형 광고주 자동화를 가능하게 할 것입니다.

Meta’s Generative Ads Model (GEM): The Central Brain Accelerating Ads Recommendation AI Innovation

We’re sharing details about Meta’s Generative Ads Recommendation Model (GEM), a new foundation model that delivers increased ad performance and advertiser ROI by enhancing other ads recommendation …

engineering.fb.com

이글을 기반으로 디지털마케터가 Meta GEM최적화를 위해 고려해야 할 것들과 필수 가이드 5가지를 소개 합니다.

[인사이트] 디지털 마케터가 알아야 할 GEM(Generative Ads Recommendation Model)의 핵심과 성과 최적화 전략

[인사이트] 디지털 마케터가 알아야 할 GEM(Generative Ads Recommendation Model)의 핵심과 성과 최적화 전

💡이번 콘텐츠는 Meta GEM: The Central Brain Accelerating Ads Recommendation AI Innovation 의 내용을 기반으로 디지털마케터가 알아야할 GEM의 핵심성과 최적화 전략을 구성하였습니다. Meta의 GEM(Generative Ads Recomm

archives.flaneur.kr

메타(Meta) 광고 생태계의 진화: GEM 모델과 Andromeda 엔진의 상호작용 및 최적화 전략

메타(Meta) 광고 생태계의 진화: GEM 모델과 Andromeda 엔진의 상호작용 및 최적화 전략

1. 알고리즘 패러다임의 대전환과 미디어 바잉의 종말2024년 하반기부터 2025년 초에 걸쳐 메타(Meta)의 광고 플랫폼은 디지털 마케팅 역사상 가장 근본적이고 구조적인 변화를 맞이했습니다. 이는

archives.flaneur.kr

메타 광고 알고리즘 GEM + Andromeda 최적화 가이드

메타 광고 알고리즘 GEM + Andromeda 최적화 가이드

💡메타 광고 알고리즘 GEM과 Andromeda 활용 시, 최소 5개 이상의 의미론적으로 다양한 소재(5~15개 권장)를 포함하는 것이 중요합니다. Andromeda 업데이트 이후 CTR 증가, CPA 감소 등 성과 지표가 개선

archives.flaneur.kr

시퀀스 러닝: 개인화 광고 추천을 위한 패러다임의 전환 (Sequence learning: A paradigm shift for personalized

Executive Summary이 문서는 Meta가 개인화 광고 추천 시스템을 기존의 DLRM(Deep Learning Recommendation Models) 방식에서 시퀀스 러닝(Sequence Learning) 기반으로 전환한 기술적 배경과 성과를 다룹니다.문제 정의

archives.flaneur.kr